Table des matières

- 1. Concepts de bases et motivations

- 1.1. Introduction au paradigme fonctionnel

- 1.2. La machine de Turing

- 1.3. Les principes fondamentaux

- 1.4. Techniques et mécanismes clés

- 1.5. Concepts fondamentaux transversaux

- 1.6. Les avantages du paradigme

- 1.7. Comprendre la notation de la parallélisation

- 1.8. Performance et réalisations industrielles

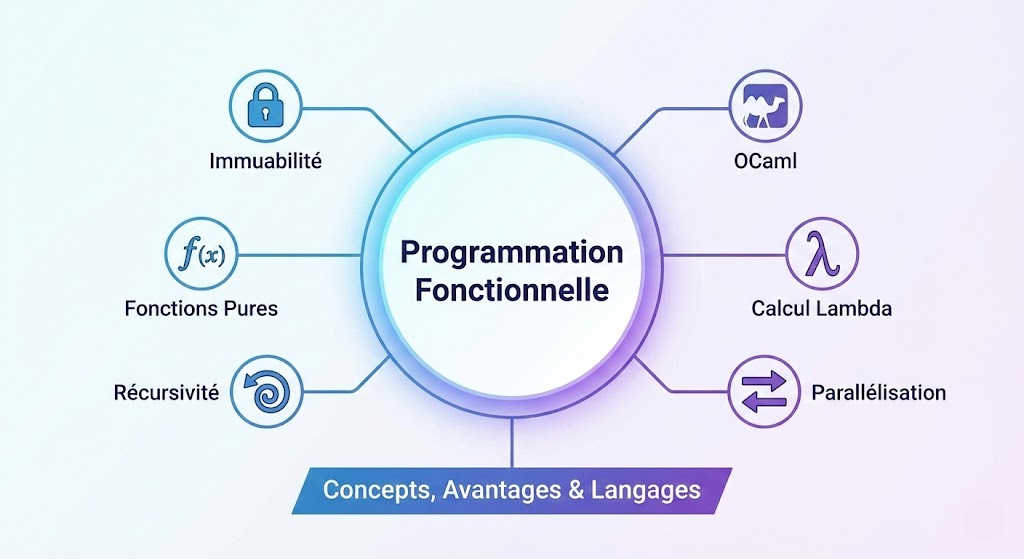

- 1.9. Panorama des langages

- 2. La récursivité

- 3. Le langage OCaml

- 4. Les fonctions en OCaml

1. Concepts de bases et motivations

1.1. Introduction au paradigme fonctionnel

Nous débutons notre étude des paradigmes de programmation par une approche qui trouve ses racines profondes dans les mathématiques: la programmation fonctionnelle. Pour comprendre l'essence de ce paradigme, nous devons d'abord réaliser que les mathématiques traditionnelles n'ont pas besoin de la notion de variable informatique telle que nous l'entendons souvent, c'est-à-dire un espace mémoire dont la valeur change au cours du temps. En algèbre, lorsque nous écrivons une équation, les symboles représentent des valeurs immuables. C'est cette philosophie que la programmation fonctionnelle transpose dans le monde du logiciel.

Cette approche offre un pouvoir expressif théoriquement infini. Il est fascinant de noter que ce paradigme n'est pas une invention récente issue de la mode technologique actuelle. Le langage LISP, par exemple, a été inventé dès 1958. Il représente une alternative historique fondamentale au modèle de la machine de Turing, qui a inspiré la programmation impérative classique basée sur la modification d'états mémoire.

1.2. La machine de Turing

Pour comprendre ce qui distingue l'approche fonctionnelle, nous devons nous pencher sur le modèle dominant de l'informatique classique : la machine de Turing. Imaginée par Alan Turing en 1936, cette abstraction mathématique définit le concept même d'algorithme mécanique. Nous pouvons la visualiser comme un ruban de papier infini divisé en cases, parcouru par une tête de lecture capable de lire, d'écrire ou d'effacer des symboles. Le fonctionnement repose entièrement sur la notion d'état: la machine lit un symbole, et en fonction de son état interne actuel, elle décide de modifier ce symbole, de déplacer la tête vers la gauche ou la droite, et de passer à un nouvel état. C'est l'essence de la programmation impérative où le calcul avance par une succession d'effets de bord et de modifications de la mémoire, s'opposant ainsi radicalement à l'immutabilité prônée par le paradigme fonctionnel.

1.3. Les principes fondamentaux

Lorsque nous programmons de manière fonctionnelle, nous adoptons une discipline stricte: nous ne manipulons pas de variables, mais uniquement des constantes. Une fois qu'une donnée est définie, elle est immuable et ne changera jamais. Cela implique un changement radical dans la structure de nos programmes. Nous ne rédigeons pas de suites d'instructions qui modifient l'état de la machine, mais nous composons des expressions. Chaque ligne de code est une question posée qui attend une réponse, et non un ordre donné à l'ordinateur. Par conséquent, il n'y a pas d'effet de bord; le programme ne produit que du résultat. Pour compenser l'absence d'instructions de contrôle classiques, les expressions utilisées sont beaucoup plus sophistiquées et se rapprochent de la notation mathématique formelle.

1.4. Techniques et mécanismes clés

Face à l'absence de variables mutables, nous devons réapprendre à effectuer des tâches élémentaires. La question qui se pose naturellement est la suivante: comment réaliser des répétitions sans boucles "for" ou "while"? La réponse réside dans la récursion. Dans ce paradigme, la récursion remplace systématiquement les structures de boucles itératives. De plus, nous traitons les fonctions comme des valeurs de première classe. Une fonction est une donnée comme une autre: elle peut être passée en argument, retournée par une autre fonction ou stockée dans une structure de données.

Pour naviguer aisément dans cet univers, nous nous appuyons souvent sur des concepts transversaux, bien que non exclusifs au fonctionnel. Nous utilisons le polymorphisme pour écrire du code générique et l'inférence automatique des types pour alléger la syntaxe. La gestion de la mémoire est également déléguée à un mécanisme automatique, le ramasse-miettes ou garbage collector, ce qui nous libère de la gestion manuelle des allocations. Bien que les types algébriques soient centraux, nous les laisserons de côté pour le cadre de cette unité d'enseignement.

1.5. Concepts fondamentaux transversaux

- Le polymorphisme: Ce mécanisme nous permet de concevoir des fonctions ou des structures de données génériques, capables de traiter différents types d'entrées sans nécessiter de réécriture. Concrètement, plutôt que de créer une fonction de tri spécifique pour les entiers et une autre distincte pour les chaînes de caractères, nous en définissons une seule, abstraite, qui s'adapte automatiquement à la nature des données manipulées. Cela augmente considérablement la réutilisabilité de notre code.

- L'inférence automatique des types vient alléger notre charge syntaxique. Dans les langages statiquement typés classiques, nous sommes souvent contraints de déclarer explicitement le type de chaque variable ou fonction. Ici, le compilateur analyse le contexte d'utilisation pour déduire logiquement le type des expressions. Nous écrivons ainsi un code plus concis, proche du script, tout en conservant la sécurité d'un typage fort vérifié à la compilation.

- Le Garbage Collector: Grâce à ce système, nous n'avons plus à nous soucier d'allouer ou de libérer manuellement la mémoire, une tâche fastidieuse qui est la source fréquente d'erreurs critiques comme les fuites de mémoire. Le système détecte automatiquement les données qui ne sont plus utilisées par le programme et recycle l'espace qu'elles occupaient.

- Les types algébriques: Bien que l'étude approfondie de ce concept dépasse le cadre strict de cette unité d'enseignement, il constitue la pierre angulaire de la modélisation des données en programmation fonctionnelle. Il s'agit d'une méthode de construction de types complexes en combinant des types existants. Cette combinaison se fait soit par une association de plusieurs valeurs, que nous appelons type produit, soit par une alternative entre plusieurs possibilités, que nous nommons type somme. Cela nous offre une précision redoutable pour décrire la structure de nos données.

1.6. Les avantages du paradigme

L'adoption de ce style de programmation nous offre des bénéfices concrets. Le premier est la lisibilité : le code tend à être plus concis et plus proche de la logique métier. Cependant, l'avantage le plus décisif à l'ère moderne concerne la parallélisation. Nous parlons souvent de parallélisation for free (ou "gratuite"). Prenons l'exemple d'une expression simple où une fonction f prend en paramètres les résultats de deux autres fonctions, g(x) et h(x). Dans un langage impératif, nous devons savoir si g modifie une variable globale que h utilise. En programmation fonctionnelle pure, cette question ne se pose pas. Comme les données sont immuables et qu'il n'y a pas d'effets de bord, g(x) et h(x) retourneront toujours la même valeur pour un x donné, indépendamment du moment de leur exécution. Nous pouvons donc exécuter g et h simultanément sur deux cœurs de processeur différents sans aucun risque de conflit. C'est une caractéristique cruciale pour les systèmes distribués actuels.

1.7. Comprendre la notation de la parallélisation

Nous devons décrypter cette notation pour saisir l'avantage majeur du paradigme fonctionnel concernant les performances sur les architectures modernes. Cette formule synthétise mathématiquement la promesse de la parallélisation for free.

f(g(x) h(x)) = f(g(x) || h(x))

Dans la partie gauche de l'équation, nous observons un appel de fonction classique. Pour évaluer la fonction f, nous devons d'abord calculer ses arguments, à savoir le résultat de g(x) et celui de h(x). Dans une approche impérative traditionnelle, ces calculs se feraient séquentiellement : l'ordinateur exécuterait d'abord g, puis h (ou inversement), avant de passer les résultats à f. La partie droite introduit une notation spécifique avec le symbole ||. Ici, ce double trait vertical ne représente pas un "OU" logique, mais symbolise une exécution en parallèle. L'expression indique que nous lançons le calcul de g(x) sur un processeur et le calcul de h(x) sur un autre, simultanément. Le symbole central d'équivalence = est la clé de voûte de ce raisonnement. Il affirme que le résultat final sera strictement identique, que les calculs soient faits l'un après l'autre ou en même temps. Cette garantie n'est possible que parce que nos fonctions sont pures. Comme g et h ne modifient aucune variable globale (pas d'effets de bord) et ne dépendent que de x, elles ne peuvent pas interférer l'une avec l'autre. Nous avons donc la certitude mathématique que la parallélisation est sûre, sans avoir besoin de mécanismes complexes de verrouillage ou de synchronisation.

1.8. Performance et réalisations industrielles

Il existe une idée reçue tenace selon laquelle la programmation fonctionnelle souffrirait de mauvaises performances. Nous devons nuancer ce propos: l'inefficacité survient seulement si l'on ne prend pas de précautions, ce qui est vrai pour n'importe quel paradigme. Pour garantir la performance, nous utilisons des techniques comme la récursion terminale (ou tail recursion). Cela permet au compilateur de transformer une fonction récursive en une boucle simple au niveau du langage machine, évitant ainsi de saturer la pile d'exécution. Si cela s'avère absolument nécessaire, il reste possible d'introduire localement de l'impératif pour optimiser un point critique, bien que cela soit rare.

L'industrie ne s'y est pas trompée et utilise ces concepts massivement. Le modèle MapReduce de Google, utilisé pour traiter des volumes massifs de données, est directement inspiré de fonctions classiques du paradigme fonctionnel. Dans le domaine des télécommunications, Ericsson a développé Erlang pour gérer des systèmes tolérants aux pannes, une technologie reprise par Facebook et WhatsApp pour gérer leurs messageries instantanées. Le secteur de la finance, avec des acteurs comme Jane Street ou Lexifi, utilise OCaml pour sa fiabilité et son expressivité.

1.9. Panorama des langages

Pour clore cette introduction, nous pouvons classer les langages selon leur adhésion à ce paradigme.

- Nous trouvons d'abord les langages purement fonctionnels, qui interdisent l'impératif, comme Haskell. R, bien que différent, partage cette pureté dans le traitement des données.

- Ensuite, nous avons les langages principalement fonctionnels, qui favorisent cette approche tout en permettant des écarts. Cette catégorie inclut Lisp, Scheme, OCaml, Scala, F#, Erlang, Clojure, et de plus en plus JavaScript.

- Certains langages modernes sont partiellement fonctionnels, intégrant ces concepts au cœur de leur design, comme Swift ou Kotlin.

- Enfin, les langages historiques comme Java, C++ ou C# ont évolué dans leurs versions récentes pour permettre l'écriture de code fonctionnel, reconnaissant ainsi l'importance incontournable de ce paradigme dans le développement logiciel contemporain.

2. La récursivité

2.1. Introduction

Nous abordons à présent un concept fondamental qui distingue nettement la programmation impérative de la programmation fonctionnelle: la gestion de la répétition. Dans nos chapitres précédents, nous avons établi que le paradigme fonctionnel interdit les effets de bord et la modification des variables après leur initialisation. Cette contrainte nous oblige à repenser la manière dont nous effectuons des traitements itératifs. Si nous ne pouvons pas modifier un compteur de boucle, comment pouvons-nous répéter une action? La réponse réside dans la récursivité.

2.2. L'approche impérative traditionnelle

Pour illustrer ce propos, penchons-nous sur un exemple mathématique classique: le calcul de la factorielle d' un nombre. Dans un langage comme Java, utilisé ici de manière impérative, nous avons l'habitude de résoudre ce problème à l'aide d'une boucle explicite.

2.3. Focus mathématique sur la factorielle

Avant d'analyser son implémentation informatique, il est essentiel de bien comprendre la définition mathématique de la factorielle. Nous désignons par ce terme une opération qui s'applique aux nombres entiers naturels. La factorielle d'un entier n est le produit de tous les nombres entiers strictement positifs inférieurs ou égaux à n. Nous notons cette opération en utilisant un point d'exclamation placé après le nombre, par exemple n!. Le calcul s'effectue en multipliant le nombre n par son prédécesseur n moins 1, puis par n moins 2, et ainsi de suite en descendant jusqu'à atteindre le nombre 1.

Prenons un exemple concret pour illustrer ce principe. Si nous souhaitons calculer la factorielle de 5, nous effectuons le calcul suivant :

- 5 multiplié par 4 donne 20

- 20 multiplié par 3 donne 60

- 60 multiplié par 2 donne 120

- 120 multiplié par 1 donne 120

Ainsi, nous disons que 5! est égal à 120.

2.4. Le cas particulier et la propriété récursive

Il existe une convention importante que nous devons mémoriser: la factorielle de 0 est définie comme étant égale à 1. Cette définition, bien que contre-intuitive au premier abord, est nécessaire pour assurer la cohérence de nombreuses formules mathématiques, notamment en probabilités et en combinatoire. Enfin, nous pouvons observer une propriété fondamentale qui servira de base à notre logique de programmation: la factorielle de n est égale à n multiplié par la factorielle de n moins 1. Par exemple, 5! est bien égal à 5 multiplié par 4!. C'est cette structure mathématique qui définit la nature récursive de l'opération.

Voici comment nous écrivons traditionnellement cette fonction:

static public int fact(int n){

int i=n, res=1;

while(i>1){

res=res*i;

i=i-1;

}

return res;

}

Analysons le fonctionnement de ce code à la lumière de nos contraintes fonctionnelles. Nous constatons que cette méthode repose entièrement sur la modification de l'état. La première ligne initialise deux variables, i et res. La boucle while modifie continuellement ces variables à chaque itération : la variable res accumule le résultat et la variable i est décrémentée. C'est précisément ce mécanisme de modification de variables, et donc d'effet de bord local, qui est interdit en programmation fonctionnelle pure. Nous ne pouvons pas utiliser cette structure.

2.5. La solution récursive

Pour respecter les principes fonctionnels, nous devons exprimer la répétition sans modifier de variables. Nous allons donc utiliser la récursivité, c'est-à-dire une fonction qui s'appelle elle-même pour résoudre une partie du problème. Voici l'équivalent fonctionnel de notre calcul de factorielle en Java:

static public int fact2 (int n){

if (n<=0) {

return 1;

} else {

return n * fact2(n-1);

}

}

Examinons comment cette fonction opère. Nous ne voyons plus aucune boucle ni aucune réaffectation de variable. À la place, nous avons une structure conditionnelle qui définit deux cas. Le premier est le cas de base: si n est inférieur ou égal à zéro, nous retournons simplement 1, ce qui arrête la récursivité. Le second est le cas récursif: nous retournons le résultat de la multiplication de n par le résultat de la fonction elle-même, appliquée à n moins 1. Nous avons remplacé l'itération par l'appel de fonction.

Exemple: Avec n=3

- La Descente (Phase d'appel) : Le programme "empile" les appels les uns sur les autres car il ne peut pas terminer le calcul actuel sans connaître le résultat du suivant.

- fact2(3): "Attends, je dois multiplier 3 par le résultat de fact2(2)..."

- fact2(2): "Attends, je dois multiplier 2 par le résultat de fact2(1)..."

- fact2(1): "Attends, je dois multiplier 1 par le résultat de fact2(0)..."

- Le Point de Rupture (Cas de base) : fact2(0): "Je connais la réponse ! C'est 1." (Il ne fait plus d'appel, il commence à renvoyer).

- La Remontée (Phase de retour) : C'est là que les multiplications se font réellement avec les valeurs obtenues.

- fact2(1) reçoit 1, fait 1x1 et renvoie 1.

- fact2(2) reçoit 1, fait 2x1 et renvoie 2.

- fact2(3) reçoit 2, fait 3x2 et renvoie 6.

À retenir: Cette approche est très élégante car elle se rapproche de la définition mathématique de la factorielle. C'est pour cela qu'on utilise l'image d'une pile (Stack): on empile les problèmes, et une fois qu'on a la solution du plus petit, on dépile tout en faisant les calculs au fur et à mesure.

3. Le langage OCaml

3.1. Introduction

Nous abordons maintenant le cœur technique de OCaml. Nous le définissons avant tout comme un langage multi-paradigmes. Cela signifie que nous ne sommes pas enfermés dans une unique façon de penser le code. Bien que le paradigme fonctionnel soit dominant et constitue la philosophie principale du langage, nous avons la liberté d'utiliser le style impératif ou la programmation orientée objet lorsque la situation l'exige.

3.2. Les fonctions comme valeurs de première classe

Une particularité centrale de notre apprentissage réside dans le statut des fonctions. Dans ce langage, une fonction est une valeur comme les autres. Nous pouvons la stocker dans une variable, la passer en argument à une autre fonction ou la retourner comme résultat. C'est ce qui nous permet de qualifier OCaml de langage d'ordre supérieur. Pour visualiser ce concept, regardons comment nous déclarons une fonction simple qui élève un nombre au carré :

let carre x = x * xNous voyons ici une syntaxe très dépouillée. Le mot-clé let introduit la définition, suivi du nom de la fonction et de son argument x. Ce qui est remarquable, c'est l'absence d'annotations de types explicites. Le système comprend seul que l'opérateur de multiplication s'applique à des nombres et déduit le reste.

3.3. Syntaxe

3.3.1. La notion de constante et l'expression

Dans notre exploration du paradigme fonctionnel avec OCaml, nous devons opérer un changement de perspective fondamental concernant le stockage des données. Contrairement aux habitudes que nous avons pu prendre avec des langages impératifs, nous ne parlons pas ici de variables qui mutent au fil du temps. Nous manipulons exclusivement des constantes. Une fois qu'une valeur est calculée et liée à un nom, elle ne change plus. Pour structurer nos calculs, nous utilisons un mécanisme de définition locale.

let x = 1 in

x + 3

Nous observons ici la syntaxe canonique de la définition locale. La structure commence par le mot-clé let, suivi du nom que nous souhaitons donner à notre constante, ici x. Le signe égal introduit la valeur associée, ici 1, qui n'est calculée qu'une seule fois. Le mot-clé in est crucial car il marque la transition entre la définition et son utilisation. Enfin, nous trouvons l'expression x + 3 où notre constante prend tout son sens.

3.3.2. L'imbrication des expressions et la portée des définitions

Il est important de comprendre que OCaml raisonne entièrement en termes d'expressions. La structure du langage nous permet d'empiler des définitions locales les unes dans les autres, créant ainsi des contextes d'évaluation successifs. Nous ne sommes pas limités à une seule définition; nous pouvons en enchaîner autant que nécessaire pour préparer nos données avant le calcul final.

let x = 1 in

let y = 1 + x in

if x < y then

x + y + 3

else 0

Dans cet exemple, nous observons une hiérarchie stricte. La première ligne initialise x. Tout ce qui suit le premier mot-clé in constitue le corps de cette première définition. C'est à l'intérieur de ce corps que nous définissons y. Cette structure en gigogne a une conséquence directe sur la visibilité des données, un concept que nous appelons la portée. Comme x est défini au niveau le plus haut, il est visible et utilisable dans toutes les sous-expressions qui suivent. À l'inverse, y n'est visible que dans la partie la plus interne du code, c'est-à-dire dans le bloc if.

4. Les fonctions en OCaml

4.1. Les fonctions et le paradigme fonctionnel en OCaml

En OCaml, l'appel d'une fonction se fait de la manière la plus épurée possible. Nous n'utilisons ni parenthèses ni virgules pour séparer les arguments. Nous écrivons simplement le nom de la fonction suivi de ses arguments, séparés par des espaces.

let x = 12 + 2 * int_of_string "456" in

compare x 23

Dans cet exemple, nous voyons que la fonction int_of_string reçoit la chaîne de caractères "456" directement. Ensuite, nous affectons le résultat de notre calcul mathématique à x. Enfin, la fonction compare est appelée avec les arguments x et 23.

4.2. L'ordre supérieur et les fonctions comme valeurs

Dans le paradigme fonctionnel, une fonction est une valeur strictement comme une autre. Elle peut être affectée à une variable, passée en paramètre ou retournée par une autre fonction. C'est ce que nous appelons l'ordre supérieur. Nous introduisons une fonction, souvent anonyme, avec le mot-clé fun suivi du paramètre et d'une flèche pointant vers l'expression à évaluer.

let a = fun x -> 2 * x + 1 in

a 8

4.3. La récursivité

Pour définir une fonction qui fait appel à elle-même, nous devons explicitement indiquer qu'elle est récursive en ajoutant le mot-clé rec juste après let.

let rec fact = fun x -> if x = 0 then 1 else x * fact (x - 1) in

fact 6

Nous définissons ici la célèbre fonction factorielle. Le mot-clé rec permet à l'identifiant fact d'être disponible et appelable à l'intérieur de sa propre définition.

4.4. Bilan et rayonnement du paradigme fonctionnel

En conclusion, nous retenons que le langage OCaml repose sur l'évaluation exclusive d'expressions. Les fonctions y règnent en tant que valeurs absolues, manipulables, retournables et composables à l'infini. En complément, le langage met à notre disposition des types algébriques performants et un mécanisme d'inférence de types polymorphes qui garantit l'intégrité du programme tout en préservant la clarté de la syntaxe. Aujourd'hui, ces préceptes fonctionnels ont largement franchi les portes de la recherche universitaire pour devenir des standards incontournables de l'industrie logicielle globale. Maîtriser le paradigme fonctionnel n'est donc pas une simple curiosité académique, mais une compétence fondamentale pour concevoir des logiciels fiables, évolutifs et élégants dans n'importe quel écosystème technologique actuel.